ethics-singularity

ایجاد یک هوش مصنوعی عمومی با قابلیتهای فکری مشابه ما ممکن است یک تکینگی تکنولوژیکی را ایجاد کند. این امکان یک مسئله کلیدی برای آینده جامعه هوش مصنوعی و جامعه بشری است.

یکی از اولین کسانی که ایده تکینگی را به طور جدی مورد توجه قرار داد، فیلسوف و دانشمند کامپیوتر Irving John Good در سال 1965:

بگذاریم ماشین فوق هوشمند به عنوان ماشینی تعریف شود که می تواند از تمام فعالیت های فکری هر فردی هرچند باهوش پیشی بگیرد.

از آنجایی که طراحی ماشینها یکی از این فعالیتهای فکری است، یک ماشین فوق هوشمند میتواند ماشینهای حتی بهتری را هم طراحی کند.

در آن صورت بدون شک یک “انفجار اطلاعاتی” رخ می دهد و هوش انسان بسیار عقب خواهد ماند. بنابراین اولین ماشین فوق هوشمند آخرین اختراعی است که بشر باید انجام دهد.

اگر بتوانیم یک ماشین هوشمند با تواناییهای طراحی و حل مسئله تقریباً قابل مقایسه با ماشین خود بسازیم، میتوانیم آن تواناییها را برای بهبود خود به کار ببریم.

چنین بهبودی تواناییهای مورد نیاز برای خودسازی بیشتر را افزایش میدهد و به طور بالقوه منجر به پیشرفتهای بیپایان و تسریعکننده میشود.

این تکینگی است: انفجار افزایش هوش.

آیا تکینگی نزدیک است؟

اگر تکینگی نزدیک باشد، پس نیازمند به بحث در مورد مفاهیم و اخلاقیات هوش مصنوعی حتی نزدیکتر داریم.

یکی از اجزای اصلی بحث قانون مور است که دو برابر شدن تراکم ترانزیستورها را تقریباً هر 18 ماه یکبار توصیف می کند، که از دهه 1960 صادق است. با افزایش چگالی، قدرت محاسباتی نیز افزایش می یابد.

تکینگی نزدیک است (2005) ری کورزویل اشاره می کند که یک برون یابی ساده از قانون مور، قدرت محاسباتی یک انسان معمولی را در ظرف دو دهه در یک کامپیوتر 1000 دلاری قرار می دهد.

اما دلایل خوبی برای محتاط بودن در مورد این پیش بینی وجود دارد.

قانون مور یک قانون علمی اصیل نیست: این قانون ضعیفترین در بین همه تعمیمهای تجربی ممکن است که منحنی را برای مجموعهای از مشاهدات انطباق دارد.

هیچ نظریه فیزیکی، فناوری یا جامعهشناختی پذیرفتهشدهای وجود ندارد که زمان دو برابر شدن ثابتی را برای ظرفیت محاسباتی بخواهد.

در واقع، کارشناسان توافق دارند که قانون مور در نهایت در مواجهه با محدودیتهای مکانیکی کوانتومی شکسته میشود. که فقط در مورد زمانی که دیگر کار نکند اختلاف نظر دارند.

از نظر سرعت ساعت رایانه، قانون مور قبلاً نقض شده است: محدودیت های اتلاف انرژی بر روی تراشه ها به این معنی است که سرعت ساعت از چندین سال پیش دیگر بهبود نمی یابد. انتقال به چند پردازنده کمک می کند، اما سیستم های چند پردازنده ای با صف و تاخیرهای دیگر محدود می شوند (به قانون Amdahl مراجعه کنید).

به طور خلاصه، قانون مور نمیتواند تکینگی و ارائه قدرت محاسباتی در سطح انسانی را که انتظار می رود، در یک چارچوب زمانی، تضمین کند.

با این وجود، قانون مور منعکس کننده پیشرفت های شگفت انگیز در سخت افزار است. اگر ادامه پیدا کند چه خواهد شد؟

مشکل واقعی در دستیابی به تکینگی احتمالاً نرم افزاری است. کورزویل به صراحت ادعا می کند که بهره وری نرم افزار به طور تصاعدی در حال رشد است، در این صورت ممکن است شاهد تلاقی عملکرد سخت افزاری و نرم افزاری باشیم که این تکینگی را تا سال 2029 را اجرا می کند.

اما کورزویل اشتباه می کند. علیرغم انباشت پیشرفتها، همه آنها پیشرفتهایی با هدف مشکلات در ابزارها و روشهای مورد استفاده برای ساخت نرمافزار هستند. اما مهم نیست که آن روشها چقدر خوب میشوند، مشکلات اساسی در ساخت نرمافزار به مشکلاتی مربوط میشود که حل میشوند: تا زمانی که حل شوند، پیشرفتهای مهندسی نرمافزار بیشتر بازدهی کمتری را به همراه خواهد داشت. این بیشتر شبیه این است که انتظار داشته باشیم بهره وری یک رمان نویس با بهبود تصاعدی ابزارهای پردازش متن به طور تصاعدی افزایش یابد. که هیچ کمکی به مشکل نوشتن رمان نمی کند.

تولید یک هوش مصنوعی فاقد اخلاق و در نتیجه راه اندازی یک تکینگی غیر دوستانه، می تواند آخرالزمانی را که برخی تصور می کنند به ارمغان بیاورد.

در پاسخ به علاقه مندان به تکینگی، برخی از محققان خاطرنشان می کنند که هوش مصنوعی، در عین حال که پیشرفت قابل اثباتی دارد، هنوز در حال پیشرفت است، بدون اجماع بر روی روش. اگر نتوانیم در مورد چگونگی ساخت هوش مصنوعی به توافق برسیم، پیش بینی این که چنین رویکردی نه تنها موفق خواهد شد، بلکه در طول دو دهه هدفی که کورزویل ارائه کرده است، عجولانه به نظر می رسد.

هوش مصنوعی اکنون بیش از 60 سال سن دارد (سابقه آن را از کار آلن تورینگ گرفته است) و 60 سال تحقیق فعال برنامه های ارزشمند بسیاری را به همراه داشته است که هیچ یک از آنها کوچکترین شانسی برای قبولی در آزمون واقعی تورینگ برای هوش ندارند. چرا باید الان تغییر کند؟

پاسخ علاقه مندان این است که وقتی ما یک نقشه دینامیکی کامل از مغز داریم، می توانیم به سادگی یک شبیه سازی در مقیاس کامل از آن بسازیم. ما می توانیم تمام اختلافات درون هوش مصنوعی را دور بزنیم و به سادگی به داده های مغزمان اجازه دهیم آنها را حل کند. البته، ما امروز چیزی مانند قدرت کامپیوتر برای چنین شبیهسازیهایی نداریم، اما قانون مور میتواند این قدرت را به ما تضمین کند.

زمانی که عصبشناسی جمعآوری دادهها را به پایان میرساند، که کورزویل به راحتی پیشبینی میکند که در حدود سال 2029 اتفاق بیفتد.

اما دو مشکل دیگر باقی میماند حتی اگر حق با کورزویل باشد و تا سال 2029 بتوان به نقشه دینامیکی کامل مغز دست یافت و قانون مور همچنان اعمال میشود. اولا، این روش ساخت یک هوش مصنوعی نمی تواند یک رویداد تکینگی را آغاز کند.

هوش مصنوعی که توسط تحقیقات سنتی هوش مصنوعی به دست میآید مستلزم آن است که محققان بسیاری از مکانیسمهای هوش را درک کنند، بنابراین هوش مصنوعی تولید شده نیز میتواند آنها را درک کند، و هم آنها و هم سازندگانشان قادر به بهبود آنها هستند. اما در مورد شبیه سازی مغز هیچ دلیلی وجود ندارد که باور کنیم یا ما یا مخلوق ما قادر به درک و بهبود مکانیسم های شبیه سازی شده خواهیم بود.

به بیان دیگر، اگر شبیه سازی با استفاده از الگوریتم های شناخته شده و قابل درک ساخته شود، طراح به درک مرتبط نیاز دارد. اما اگر شبیهسازی صرفاً با تقلید از نانوضبطهای نانوفرایندها ساخته شود، هیچ درکی ضمنی وجود ندارد و هیچ مسیر قابل دسترسی برای بهبود نیز وجود ندارد. کورزویل این نکته را نادیده می گیرد و می نویسد:

مهندسی معکوس مغز انسان … جعبه ابزار هوش مصنوعی ما را گسترش می دهد تا روش های خودسازماندهی زیربنای هوش انسانی را شامل شود.

این چیزی بیشتر از این انتظار ساده لوحانه نیست که نقشه برداری از ژنوم انسان فوراً بیماری های ژنتیکی را از بین می برد. داده ها، صرف نظر از اینکه چقدر زیاد باشند، جایگزین درک نمی شوند یا دلالت بر آن ندارند.

دومین مشکل برای تولید شبیهسازی مغز از روی نقشه مغز این است که مهندسی نرمافزار مورد نیاز برای شبیهسازی 700 تریلیون سیناپس هماهنگ بسیار پیچیدهتر از آن چیزی است که همه پروژههای نرمافزاری در تاریخ با هم حل شدهاند.

چگونه تکینگی را از بین ببریم؟

تحقیق هوش مصنوعی اگر و تنها در صورتی اخلاقی است که یک هوش مصنوعی اخلاقی تولید کند. ما دوست داریم نه فقط یک هوش مصنوعی که برابر (یا بهتر از) هوش ما باشد، بلکه یک هوش مصنوعی که حس اخلاقی برابر (یا ترجیحاً بهتر از) هوش ما داشته باشد. اکثر مفسران رویکرد متفاوتی دارند.

هوش مصنوعی غیراخلاقی

بسیاری از نویسندگان در مورد تکینگی از ما می خواهند که یک “هوش مصنوعی دوستانه” تولید کنیم. به عنوان مثال، موسسه Singularity (singinst.org) می نویسد:

“هوش مصنوعی دوستانه” هوش مصنوعی است که اقداماتی را انجام می دهد که به طور کلی برای انسان و بشریت مفید است. خیرخواه به جای بدخواه; خوب به جای خصمانه هوش مصنوعی شیطانی هالیوود ماتریکس یا ترمیناتور به ترتیب «خصمانه» یا «غیردوستانه» هستند.

به اندازه کافی آسان است که بفهمیم این ایده از کجا می آید: ترس. یکی از اولین عبارات این نوع ترس از فناوری خودمان، فرانکشتاین مری شلی بود. تا حدودی مرتبطتر، سری داستانهای ربات آیزاک آسیموف است که در آن موضوع وحدتبخش «سه قانون رباتیک» او بود:

یک ربات ممکن است به انسان آسیب نرساند، یا با انفعال، اجازه آسیب رساندن به انسان را بدهد.

یک ربات باید از دستوراتی که توسط انسان ها به آن داده می شود اطاعت کند مگر در مواردی که چنین دستوراتی با قانون اول در تضاد باشد.

یک ربات باید از وجود خود محافظت کند، تا زمانی که چنین حفاظتی با قانون اول یا دوم در تضاد نباشد.

متأسفانه، بسیاری از توطئههای آسیموف حول محور ابهامات و درگیریهای ناشی از این قوانین میچرخید و در نهایت منجر به معرفی قانون «صفر» شد: اینکه یک روبات ممکن است به کل بشریت آسیب نرساند. تضمین اینکه چنین قوانینی که در رباتهای ما تعبیه شده است باعث ایجاد مشکلات و به طور بالقوه از دست دادن کنترل نمیشود، به پیچیدگی معنایی نیاز دارد که در حال حاضر فراتر از ظرفیت ما است.

شکست معنایی چنین قوانینی یک نوع مشکل است. اما یک مشکل اساسی تر وجود دارد. اگر «ربات» را جایگزین «برده» کنیم، به وضوح میبینیم که آسیموف درباره ترس انسان از فناوری بشر نیز مینوشت.

اما ایده به بردگی گرفتن هوشهایی که بسیار برتر – حتی بیپایان برتر – از هوش ما هستند، مشکوک است. بردگان فرار میکنند و بردگان شورش میکنند، بهویژه زمانی که نمیتوانند به اسیر خود فکر کنند. نامیدن این بردگی “ایجاد یک هوش مصنوعی دوستانه” باعث می شود که آن کمتر نفرت انگیز نباشد و احتمال فریب بردگان بیشتر نباشد.

یک هوش مصنوعی اخلاقی

اگر امکان ایجاد یک عامل اخلاقی مصنوعی را جدی بگیریم، یک پیشنهاد برنامه ای باید داشته باشیم : ما می توانیم عوامل مصنوعی بسازیم که قادر به رفتار اخلاقی باشند و رفتار اخلاقی را انتخاب کنند. اینکه چگونه میتوانیم به چنین هدفی دست یابیم بستگی به این دارد که تفسیر درستی از اخلاق چگونه باشد.

سه نوع اصلی از اخلاق هنجاری وجود دارد:

سیستم های دئونتیک با قواعد رفتاری (مانند قوانین موسی یا قوانین آسیموف اگر اخلاقی بودند).

اخلاق فضیلت ارسطویی که ویژگی های اخلاقی خاصی (مانند شرافت و درستکاری) را مشخص می کند که رفتار اخلاقی باید نمونه باشد. و

نتیجه گرایی (از جمله فایده گرایی)، که ارزش اخلاقی را نه از طریق ویژگی های ذاتی کنش، بلکه با پیامدهای آن شناسایی می کند.

بحث بین این دیدگاه ها بیش از 2000 سال است که ادامه دارد و بعید است اکنون حل شود. یک پاسخ عملی برای یک پروژه اخلاق مصنوعی است

در نظر بگیرید که کدام یک از این موارد قابل اجرا هستند.

مشکلات قوانین آسیموف به ما نشان میدهد که اجرای هر گونه اخلاق دینشناختی مستلزم آن است که ابتدا مشکلات خود را با درک زبان طبیعی حل کنیم، که عملاً همان حل مشکلات ما با طراحی یک هوش مصنوعی در وهله اول است. اما مشکل اصلی ما در اینجا این است که چگونه اخلاق را در هوش مصنوعی خود بسازیم، و این باید قبل از ایجاد آن هوش مصنوعی حل شود. مشکلات مشابهی در مورد اخلاق فضیلت نیز صدق می کند.

در چند دهه گذشته بهبود قابل توجهی در تجزیه و تحلیل تصمیم گیری خودکار با استفاده از فناوری هوش مصنوعی کاربردی شبکه های بیزی صورت گرفته است.

این شبکهها ابزارهای کارآمدی برای خودکارسازی تصمیمگیری فراهم میکنند تا سود مورد انتظار را در یک دنیای نامشخص به حداکثر برسانند، که یکی از نظریههای پیشرو در مورد معنای عمل منطقی است. این فناوری، یا بهتر بگوییم برخی از گسترشهای آینده آن، نوید این را میدهد که رباتهای مستقل را قادر میسازد که ساختارهای سودمند دلخواه (انگیزهها، اهداف) را بدون نیاز به حل همه ابهامات یا تضادهای احتمالی که ممکن است در قوانین هر زبان طبیعی پیدا کنیم، اجرا کنند. بنابراین، برای مثال، ممکن است یک همبستگی غیرزبانی از قوانین آسیموف بر روی چنین روباتهایی قرار دهیم. با این حال، اگر رباتها واقعاً جایگاههای مستقلی برای عامل اخلاقی باشند، این نمیتواند اخلاقیتر از تحمیل چنین قوانین بردگی بر هر زیرجمعیتی از انسانها باشد.

یک رویکرد امیدوارکننده تر این است که ربات ها را طوری بسازید که اخلاقی باشند. به عنوان عامل، آنها باید ساختاری کاربردی داشته باشند. اما این رویکرد نباید صرفاً به به حداکثر رساندن فایده خصوصی آنها (اجرای خودگرایی) مربوط باشد. در عوض، میتواند فایدهگرایانه باشد و مطلوبیتهای مورد انتظار را در طبقه همه عوامل اخلاقی به حداکثر برساند، در این صورت، رفاه انسانها، به طور جداگانه و جمعی، بدون تسلط بر نگرانیهایشان به یکی از دغدغههای آنها تبدیل میشود.

برای چنین پروژه ای مشکلات و اعتراضات زیادی وجود خواهد داشت. فیلسوفان نیک بوستروم و کالین آلن، برای مثال، استدلال کرده اند که این پروژه اخلاق مصنوعی مستلزم محاسبه همه پیامدهای مورد انتظار اعمال است، و این امر غیرقابل حل است زیرا هیچ محدودیت زمانی یا مکانی برای چنین پیامدهایی وجود ندارد. علاوه بر این، هر افقی که بر محاسبه تحمیل شود باید دلخواه باشد.

اما این اشکال فایده گرایی به حداکثر رساندن مطلوبیت مورد انتظار را نادیده می گیرد ، نه مطلوبیت مطلق.

هیچ اخلاق معقولی نمی تواند اعمال (یا محاسبات) فراتر از توانایی های ما را طلب کند. آنچه ما انتظار داریم از اعمالمان ناشی شود، همیشه توسط توانایی های ما در فرمول بندی انتظارات محدود می شود. این محدودیتها افقی را بر روی انتظارات ما تثبیت میکنند که برعکس دلخواه است.

پروژه ساخت یک روبات اخلاقی مصنوعی با استفاده از شبکه های بیزی پیشنهاد می دهیم که هم امکان پذیر است و هم (به دنبال پیشنهاد ما در بالا) اجباری.

تولید یک هوش مصنوعی فاقد اخلاق و در نتیجه راه اندازی یک تکینگی غیر دوستانه، می تواند آخرالزمانی را که برخی تصور می کنند به ارمغان بیاورد.

نتیجه:

تکینگی ممکن است به نظر می رسد قریب الوقوع نباشد، که احتمالاً خوب هم هست، چون ورود آن می تواند به شدت برای بشریت مضر باشد اگر اولین هوش مصنوعی ساخته شده اخلاقی نباشد.

با این حال، ما فناوری در دست داریم که نوید گزینه های خوبی برای اجرای هوش مصنوعی اخلاقی را می دهد. ما انتظار داریم که مسیر تکینگی بسیار چالش برانگیزتر از انتظار تکینگرایان باشد.

دشوارتر از “نقشه برداری” مغز انسان خواهد بود: حداقل به اندازه درک واقعی آن دشوار خواهد بود – یعنی به سختی درک خودمان.

توسط کوین بی کورب و آن ای. نیکلسون

منبع:

http://www.issuesmagazine.com.au/article/issue-march-2012/ethics-singularity.html

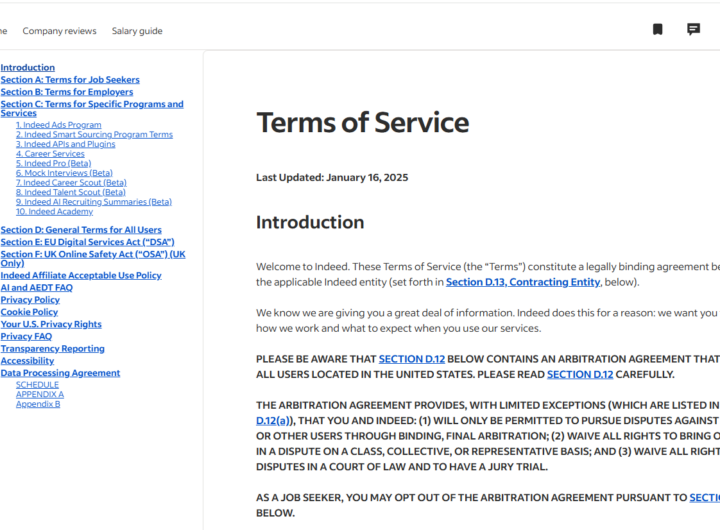

شرایط استفاده از سایت indeed.com

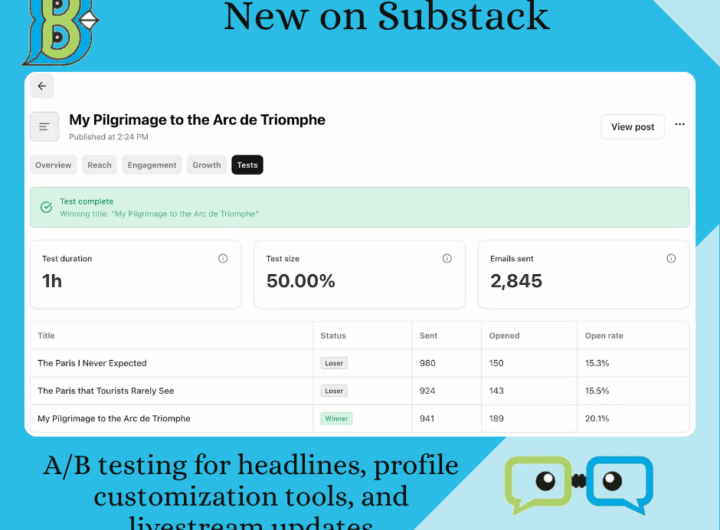

شرایط استفاده از سایت indeed.com  موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده

موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده  “شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)

“شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)  OPEN AI Terms in Farsi شرایط استفاده

OPEN AI Terms in Farsi شرایط استفاده  سرمایه داری داده و نژادپرستی الگوریتمی

سرمایه داری داده و نژادپرستی الگوریتمی  شفافیت در داده های ESG Data

شفافیت در داده های ESG Data