شرکتها بهسرعت یاد میگیرند که هوش مصنوعی تنها راهحلها را مقیاسبندی نمیکند، بلکه ریسک را نیز کاهش میدهد.

در این محیط، داده ها و اخلاق هوش مصنوعی ضروریات تجاری هستند، نه فقط یک کنجکاوی دانشگاهی.

شرکت ها برای مقابله با معضلات اخلاقی این فناوری جدید نیاز به یک برنامه روشن دارند.

شرکتها از دادهها و هوش مصنوعی برای ایجاد راهحلهای مقیاسپذیر استفاده میکنند – اما خطرات اعتباری، قانونی و قانونی خود را نیز کاهش میدهند.

به عنوان مثال، لس آنجلس از IBM به دلیل سوء استفاده از داده هایی که با برنامه آب و هوای همه جا حاضر خود جمع آوری کرده است، شکایت کرده است.

Optum توسط تنظیم کننده ها برای ایجاد الگوریتمی بررسی می شود که ظاهراً توصیه می کند که پزشکان و پرستاران به بیماران سفیدپوست بیشتر از بیماران سیاه پوست توجه بیشتری داشته باشند.

گلدمن ساکس توسط رگولاتورها به دلیل استفاده از یک الگوریتم هوش مصنوعی که گفته میشود با اعطای محدودیتهای اعتباری بیشتر به مردان نسبت به زنان در کارتهای اپل، زنان را تبعیض میکند، مورد بررسی قرار میگیرد.

فیس بوک به طور بدنامی به کمبریج آنالیتیکا، یک شرکت سیاسی، اجازه دسترسی به اطلاعات شخصی بیش از 50 میلیون کاربر را داد.

همین چند سال پیش، بحثهای «اخلاق دادهها» و «اخلاق هوش مصنوعی» به سازمانهای غیرانتفاعی و دانشگاهیان اختصاص داشت. امروزه بزرگترین شرکتهای فناوری در جهان – مایکروسافت، فیسبوک، توییتر، گوگل و غیره – تیمهای در حال رشد سریعی را برای مقابله با مشکلات اخلاقی که از جمعآوری، تجزیه و تحلیل و استفاده گسترده از دادههای انبوه بهویژه به وجود میآیند گرد هم میآورند. زمانی که از این داده ها برای آموزش مدل های یادگیری ماشینی استفاده می شود که با نام AI شناخته می شود.

این شرکتها در حال سرمایهگذاری بر روی پاسخ به سؤالات اخلاقی که زمانی باطنی بودند، میکنند، زیرا به یک حقیقت ساده پی بردهاند: شکست در عملیاتیکردن دادهها و اخلاق هوش مصنوعی یک تهدید برای خط پایان است.

از دست دادن هدف می تواند شرکت ها را در معرض خطرات اعتباری، قانونی و قانونی قرار دهد، اما این نیمی از آن نیست. شکست در عملیاتی کردن داده ها و اخلاق هوش مصنوعی منجر به هدر رفتن منابع، ناکارآمدی در توسعه و استقرار محصول، و حتی ناتوانی در استفاده از داده ها برای آموزش مدل های هوش مصنوعی شود.

برای مثال، مهندسان آمازون طبق گزارشها سالها بر روی نرمافزار استخدام هوش مصنوعی کار میکردند، اما در نهایت این برنامه را کنار گذاشتند، زیرا نتوانستند بفهمند که چگونه مدلی بسازند که به طور سیستماتیک علیه زنان تبعیض قائل نشود. Sidewalk Labs، یکی از زیرمجموعههای گوگل، به دلیل فقدان استانداردهای اخلاقی واضح برای مدیریت دادههای پروژه، با واکنش شدید شهروندان و مقامات دولتی محلی به دلیل برنامههایشان برای ساختن یک «شهر هوشمند» مبتنی بر اینترنت اشیا در تورنتو مواجه شد. این شرکت در نهایت با از دست دادن دو سال کار و 50 میلیون دلار این پروژه را کنار گذاشت.

علیرغم هزینههای اشتباه، بیشتر شرکتها از طریق بحثهای موقت بر اساس هر محصول، با دادهها و اخلاق هوش مصنوعی دست و پنجه نرم میکنند. بدون وجود پروتکل روشنی در مورد چگونگی شناسایی، ارزیابی و کاهش خطرات، تیمها در نهایت یا ریسکها را نادیده میگیرند، به تلاش برای حل مشکلات در حین بروز مشکل میپردازند، یا به امید اینکه مشکل خود به خود حل شود، دست به کار میشوند. زمانی که شرکتها تلاش کردهاند تا با این موضوع در مقیاس مقابله کنند، تمایل به اجرای سیاستهای سختگیرانه، غیردقیق و بیش از حد گسترده دارند که منجر به مثبت کاذب در شناسایی ریسک و جلوگیری از تولید میشود.

وقتی فروشندههای شخص ثالث را معرفی میکنید، ممکن است اصلاً به این سؤالات فکر نکرده باشند، که این مشکلات به مراتب بزرگتر میشوند.

شرکتها به برنامهای برای کاهش ریسک نیاز دارند – نحوه استفاده از دادهها و توسعه محصولات هوش مصنوعی بدون افتادن در دامهای اخلاقی در طول مسیر.

درست مانند سایر استراتژیهای مدیریت ریسک، یک رویکرد عملیاتی شده به دادهها و اخلاق هوش مصنوعی باید به طور سیستماتیک و جامع خطرات اخلاقی را در سراسر سازمان، از فناوری اطلاعات تا منابع انسانی، بازاریابی تا محصول و فراتر از آن، شناسایی کند.

چه کاری نباید انجام داد

با کنار گذاشتن شرکتهای فناوری بزرگتر، سه رویکرد استاندارد برای کاهش ریسک اخلاقی دادهها و هوش مصنوعی وجود دارد که هیچکدام به ثمر نمیرسند.

1- رویکرد آکادمیک :

دانشگاهیان در تحقیق دقیق و سیستماتیک فوق العاده هستند. آن دسته از دانشگاهیان که اخلاقگرا هستند (معمولاً در گروههای فلسفه یافت میشوند) در تشخیص مشکلات اخلاقی، منابع آنها و نحوه اندیشیدن در آنها مهارت دارند.

اما در حالی که ممکن است متخصصان اخلاق دانشگاهی با توجه به نیاز به شناسایی سیستماتیک و کاهش خطرات اخلاقی یک تطابق کامل به نظر برسند، متأسفانه تمایل دارند سوالات متفاوتی نسبت به مشاغل بپرسند. در بیشتر موارد، دانشگاهیان می پرسند: «آیا باید این کار را انجام دهیم؟ آیا به طور کلی برای جامعه خوب است؟ آیا به شکوفایی انسان کمک می کند؟» از سوی دیگر، کسبوکارها تمایل دارند که بپرسند: «با توجه به اینکه ما این کار را انجام میدهیم، چگونه میتوانیم بدون آسیبپذیری در برابر خطرات اخلاقی این کار را انجام دهیم؟»

نتیجه درمانهای آکادمیک است که با سطح بالایی از دانشآموزان صحبت نمیکند

کاربردهای دقیق داده ها و هوش مصنوعی. این به عدم وجود دستورالعملهای واضح برای توسعهدهندگان در زمین و رهبران ارشد است که نیاز به شناسایی و انتخاب از میان مجموعهای از استراتژیهای کاهش ریسک دارند.

2- رویکرد “روی زمین” است. در مشاغل، کسانی که سؤالات را می پرسند مهندسان، دانشمندان داده و مدیران محصول هستند. آنها می دانند دقیقاً سؤالات مربوط به ریسک مربوط به کسب و کار را بپرسند زیرا آنها هستند که محصولات را برای دستیابی به اهداف تجاری خاص می سازند. با این حال، چیزی که آنها فاقد آن هستند، نوع آموزشی است که دانشگاهیان دریافت می کنند. در نتیجه مهارت، دانش و تجربه پاسخگویی منظم، جامع و کارآمد به سؤالات اخلاقی را ندارند. آنها همچنین فاقد یک عنصر حیاتی هستند: حمایت نهادی.

3- در نهایت، شرکتهایی وجود دارند (بدون در نظر گرفتن کشورها) که اصول اخلاقی هوش مصنوعی سطح بالا را ارائه میکنند. به عنوان مثال، گوگل و مایکروسافت سال ها پیش اصول خود را در بوق و کرنا کردند. مشکل در عملیاتی کردن این اصول است. منظور از “انصاف” بودن دقیقاً چیست؟ مهندسان هنگام مواجهه با ده ها تعریف و معیارهای همراه برای عدالت در ادبیات علوم کامپیوتر چه باید بکنند؟ کدام معیار در هر مورد خاص مناسب است و چه کسی آن را قضاوت می کند؟ برای اکثر شرکت ها – از جمله آن دسته از شرکت های فناوری که فعالانه در تلاش برای حل مشکل هستند – هیچ پاسخ روشنی برای این سؤالات وجود ندارد. در واقع، ادغام ظاهری حول مجموعهای از ارزشهای انتزاعی مشترک در واقع عدم همسویی گسترده را پنهان میکند.

نحوه عملیاتی کردن داده ها و اخلاق هوش مصنوعی

اخلاق هوش مصنوعی را نمی توان در یک جعبه گذاشت. با توجه به ارزشهای متفاوت شرکتها در صنایع مختلف، یک برنامه اخلاقی دادهها و هوش مصنوعی باید بر اساس نیازهای تجاری و نظارتی خاص مرتبط با شرکت تنظیم شود. با این حال، در اینجا هفت قدم به سمت ایجاد یک برنامه داده های سفارشی، عملیاتی، مقیاس پذیر و پایدار و اخلاق هوش مصنوعی آورده ایم.

- زیرساخت های موجود را شناسایی کنید که یک برنامه اخلاقی داده و هوش مصنوعی می تواند از آن استفاده کند. کلید ایجاد موفقیتآمیز یک برنامه اخلاقی دادهها و هوش مصنوعی، استفاده از قدرت و اختیارات زیرساختهای موجود است، مانند هیئت مدیره دادهها که برای بحث در مورد حریم خصوصی، سایبری، انطباق و سایر خطرات مربوط به دادهها تشکیل جلسه میدهد. این اجازه میدهد تا نگرانیهای «در زمین» (مانند صاحبان و مدیران محصول) افزایش یابد و در صورت لزوم، آنها میتوانند به نوبه خود نگرانیهای کلیدی را به مدیران مربوطه ارتقا دهند.

به کار گرفتن هیئت مدیره به چند اجرایی است:- سطح اجرایی نحوه برخورد جدی کارکنان با این مسائل را تعیین می کند،

- یک استراتژی اخلاقی داده ها و هوش مصنوعی باید با داده های کلی و استراتژی هوش مصنوعی هماهنگ باشد که در سطح اجرایی، و

- محافظت از نام تجاری در برابر خطرات اعتباری، نظارتی و قانونی در نهایت یک مسئولیت C-suite است، و آنها باید در صورت بروز مشکلات بالا هشدار داده شوند. اگر چنین ارگانی وجود نداشته باشد، شرکتها میتوانند برای مثال یک شورای اخلاق یا کمیته با پرسنل مرتبط با اخلاق، مانند افرادی که در زمینه سایبری، ریسک و انطباق، حریم خصوصی، و تجزیه و تحلیل هستند، ایجاد کنند. همچنین ممکن است توصیه شود که متخصصان موضوعی خارجی، از جمله متخصصان اخلاق را نیز شامل شود.

- یک چارچوب ریسک اخلاقی داده ها و هوش مصنوعی ایجاد کنید که متناسب با صنعت شما باشد. یک چارچوب خوب حداقل شامل بیان استانداردهای اخلاقی – از جمله کابوس های اخلاقی – شرکت، شناسایی ذینفعان خارجی و داخلی مربوطه، یک ساختار حاکمیتی توصیه شده، و بیان چگونگی حفظ آن ساختار است. در مواجهه با تغییر پرسنل و شرایط. ایجاد KPI و یک برنامه تضمین کیفیت برای اندازهگیری اثربخشی مداوم تاکتیکهایی که استراتژی شما را انجام میدهند، مهم است.

یک چارچوب قوی همچنین روشن می کند که چگونه کاهش ریسک اخلاقی در عملیات تعبیه شده است. به عنوان مثال، باید استانداردهای اخلاقی را که گردآورندگان داده، توسعه دهندگان محصول و مدیران و صاحبان محصول باید رعایت کنند، شناسایی کند. همچنین باید فرآیند روشنی را بیان کند که از طریق آن نگرانیهای اخلاقی به رهبری ارشد یا کمیته اخلاق ارتقا یابد. همه شرکتها باید بپرسند که آیا فرآیندهایی وجود دارد که الگوریتمهای مغرضانه، نقض حریم خصوصی و خروجیهای غیرقابل توضیح را بررسی میکنند. با این حال، چارچوب ها نیز باید متناسب با صنعت یک شرکت طراحی شوند.

در امور مالی، مهم است که در مورد چگونگی تعیین هویت های دیجیتال و اینکه چگونه تراکنش های بین المللی می توانند از نظر اخلاقی ایمن باشند، فکر کنیم. در مراقبتهای بهداشتی، باید حفاظتهای بیشتری پیرامون حریم خصوصی ایجاد شود، بهویژه که هوش مصنوعی توسعه پزشکی دقیق را امکانپذیر میسازد. در فضای خردهفروشی، جایی که موتورهای توصیه بزرگ به نظر میرسند، توسعه روشهایی برای شناسایی و کاهش تعصب انجمنی مهم است، جایی که توصیهها از انجمنهای کلیشهای و گاهی توهینآمیز با جمعیتهای مختلف سرچشمه میگیرند. - با گرفتن سرنخ از موفقیت در درمان، طرز فکر خود را در مورد اخلاق تغییر دهید. مراقبت از بسیاری از رهبران ارشد اخلاق را به طور کلی – و داده ها و اخلاق هوش مصنوعی را به طور خاص – به عنوان “فشرده” یا “فاضل” توصیف می کنند، و استدلال می کنند که به اندازه کافی “متن” نیست تا قابل عمل باشد. رهبران باید از مراقبت های بهداشتی الهام بگیرند، صنعتی که حداقل از دهه 1970 به طور سیستماتیک بر کاهش خطرات اخلاقی متمرکز شده است. به عنوان مثال، نگرانی های کلیدی در مورد اینکه چه چیزی حریم خصوصی، تعیین سرنوشت و رضایت آگاهانه را تشکیل می دهد، توسط متخصصان اخلاق پزشکی، پزشکان مراقبت های بهداشتی، تنظیم کننده ها و وکلا بررسی شده است. این بینش ها را می توان به بسیاری از معضلات اخلاقی در مورد حفظ حریم خصوصی و کنترل داده های مصرف کننده منتقل کرد.

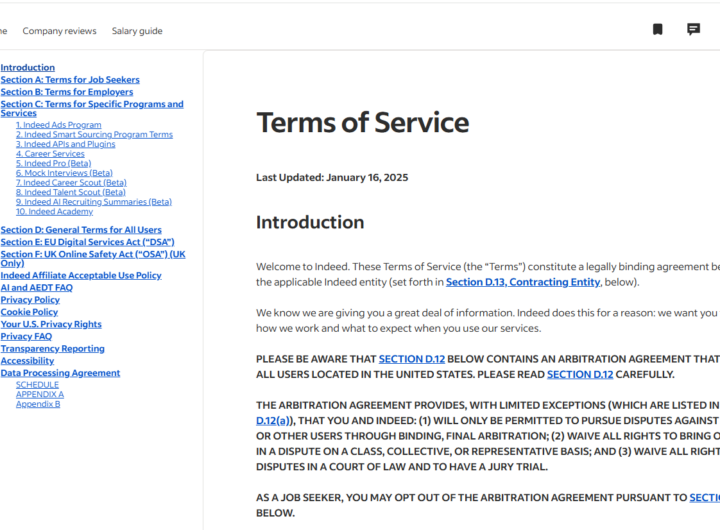

به عنوان مثال، شرکت ها می گویند که به کاربران محصولات خود احترام می گذارند، اما این در عمل به چه معناست؟ در مراقبت های بهداشتی، یک شرط اساسی برای نشان دادن احترام به بیماران این است که آنها فقط پس از اعطای رضایت آگاهانه تحت درمان قرار گیرند – که شامل رضایتی می شود که حداقل ناشی از دروغ، دستکاری یا ارتباط با کلماتی نیست که بیمار نمی تواند آن را درک کند. مانند اصطلاحات پزشکی غیرقابل نفوذ قانونی یا لاتین. همین نوع الزامات را می توان در مورد نحوه جمع آوری، استفاده و اشتراک گذاری داده های افراد اعمال کرد. اطمینان از اینکه کاربران نه تنها از نحوه استفاده از دادههایشان مطلع شدهاند، بلکه در مراحل اولیه و به گونهای که امکان درک اطلاعات را فراهم میکند (مثلاً با دفن نکردن اطلاعات در یک سند حقوقی طولانی)، بسیار آسان است. درسی که باید از مراقبت های بهداشتی گرفت درس کلی تر این است که مفاهیم اخلاقی بزرگی مانند حریم خصوصی، تعصب و توضیح پذیری را به زیرساخت ها، فرآیندها و عملکردهایی که این ارزش ها را درک می کنند، تجزیه کنیم. - بهینه سازی راهنمایی و ابزار برای مدیران محصول.

در حالی که چارچوب شما راهنمایی های سطح بالایی را ارائه می دهد، ضروری است که راهنمایی در سطح محصول دقیق باشد.

به عنوان مثال، ارزش تبیین پذیری در هوش مصنوعی را در نظر بگیرید، ویژگی بسیار ارزشمند مدل های ML که احتمالاً بخشی از چارچوب شما خواهد بود. الگوریتمهای استاندارد یادگیری ماشینی در تشخیص الگوی بسیار سختی که برای انسان قابل درک نیست، درگیر میشوند. اما معمول است – به ویژه زمانی که خروجی های AI به طور بالقوه زندگی را تغییر می دهند – خواستن یا درخواست توضیحات برای خروجی های AI. مشکل این است که اغلب تنش بین توضیحپذیر کردن خروجیها از یک سو و دقیق کردن خروجیها (مثلاً پیشبینیها) از سوی دیگر وجود دارد. مدیران محصول باید بدانند که چگونه این معاوضه را انجام دهند و ابزارهای سفارشی سازی شده باید برای کمک به مدیران محصول در تصمیم گیری ایجاد شوند. به عنوان مثال، شرکت ها می توانند ابزاری ایجاد کنند که توسط آن مدیران پروژه می توانند اهمیت توضیح پذیری یک محصول را ارزیابی کنند. اگر توضیحپذیری مطلوب است زیرا به تعیین سوگیری در یک الگوریتم کمک میکند، اما خروجیهای بایاس برای این کاربرد خاص ML نگران کننده نیستند، آنگاه اهمیت توضیحپذیری را نسبت به دقت کاهش میدهد. اگر خروجی ها تحت مقرراتی قرار می گیرند که نیاز به توضیح دارند – به عنوان مثال، مقررات در صنعت بانکداری که بانک ها را ملزم می کند توضیح دهند که چرا کسی برای دریافت وام رد شده است – آنگاه قابل توضیح است. همین امر در مورد سایر مقادیر مرتبط نیز صدق می کند، به عنوان مثال. که، در صورت وجود، از دهها معیاری که برای تعیین اینکه آیا یک محصول خروجیهای منصفانه یا عادلانه ارائه میدهد، استفاده شود. - ایجاد آگاهی سازمانی.

ده سال پیش، شرکتها به ندرت به ریسکهای سایبری توجه میکردند، اما مطمئناً اکنون به آن توجه میکنند و انتظار میرود کارمندان برخی از این خطرات را درک کنند. هر کسی که با داده ها یا محصولات هوش مصنوعی در تماس باشد – خواه در حوزه منابع انسانی، بازاریابی یا عملیات باشد – باید داده های شرکت و چارچوب اخلاقی هوش مصنوعی را درک کند. ایجاد فرهنگی که در آن یک استراتژی دادهها و اخلاق هوش مصنوعی میتواند با موفقیت به کار گرفته شود و حفظ شود، مستلزم آموزش و ارتقای مهارت کارکنان، و توانمندسازی آنها برای طرح سؤالات مهم در مقاطع حیاتی و مطرح کردن نگرانیهای کلیدی به هیئت مشورتی مناسب است. در طول این فرآیند، مهم است که به وضوح بیان کنیم که چرا داده ها و اخلاق هوش مصنوعی برای سازمان اهمیت دارد، به گونه ای که نشان دهد تعهد صرفاً بخشی از یک کمپین روابط عمومی نیست. - به طور رسمی و غیررسمی کارکنان را تشویق کنید تا در شناسایی خطرات اخلاقی هوش مصنوعی نقش ایفا کنند.

همانطور که از مثالهای بدنام بیشماری آموختهایم، زمانی که افراد انگیزه مالی برای رفتار غیراخلاقی داشته باشند، استانداردهای اخلاقی به خطر میافتند. به طور مشابه، عدم تشویق مالی به اقدامات اخلاقی می تواند منجر به بی اولویت شدن آنها شود. ارزش های یک شرکت تا حدی با نحوه هدایت منابع مالی تعیین می شود. وقتی کارمندان بودجه ای را پشت مقیاس گذاری و حفظ یک برنامه قوی داده ها و اخلاق هوش مصنوعی نمی بینند، توجه خود را به آنچه آنها را در حرفه خود به جلو می برد معطوف می کنند. پاداش دادن به افراد برای تلاش هایشان در ترویج یک برنامه اخلاق داده ضروری است. - نظارت بر تأثیرات و مشارکت ذینفعان.

ایجاد آگاهی سازمانی، کمیته های اخلاقی، صاحبان مدیران محصول آگاه، مهندسان و گردآورندگان داده ها، همگی بخشی از توسعه و ایده آل است. فرآیند تدارکات اما به دلیل محدودیت منابع، زمان و ناتوانی عمومی در تصور همه راههایی که ممکن است اشتباه پیش برود، نظارت بر تأثیرات دادهها و محصولات هوش مصنوعی موجود در بازار بسیار مهم است. یک خودرو را می توان با کیسه هوا و مناطق مچاله ساخت، اما این بدان معنا نیست که رانندگی با آن با سرعت 100 مایل در ساعت در خیابان فرعی ایمن است. به طور مشابه، محصولات هوش مصنوعی را می توان از نظر اخلاقی توسعه داد اما غیراخلاقی است. در اینجا باید تحقیقات کمی و کیفی انجام شود، از جمله جلب مشارکت سهامداران برای تعیین اینکه محصول چگونه بر آنها تأثیر گذاشته است.

در واقع، در سناریوی ایدهآل، ذینفعان مربوطه در مراحل اولیه توسعه شناسایی میشوند و در بیان کارهایی که محصول انجام میدهد و یا انجام نمیدهد، گنجانده میشوند. عملیاتی کردن داده ها و اخلاق هوش مصنوعی کار آسانی نیست. این نیاز به خرید از سوی رهبری ارشد و همکاری متقابل دارد. با این حال، شرکتهایی که سرمایهگذاری میکنند، نه تنها با کاهش ریسک مواجه میشوند، بلکه از فناوریهایی که برای پیشرفت به آنها نیاز دارند نیز به کار میروند. و در نهایت، آنها دقیقاً همان چیزی خواهند بود که مشتریان، مصرف کنندگان و کارمندان آنها به دنبال آن هستند: قابل اعتماد.

توسط رید بلکمن

15 اکتبر 2020

منبع:

https://hbr.org/2020/10/a-practical-guide-to-building-ethical-ai

شرایط استفاده از سایت indeed.com

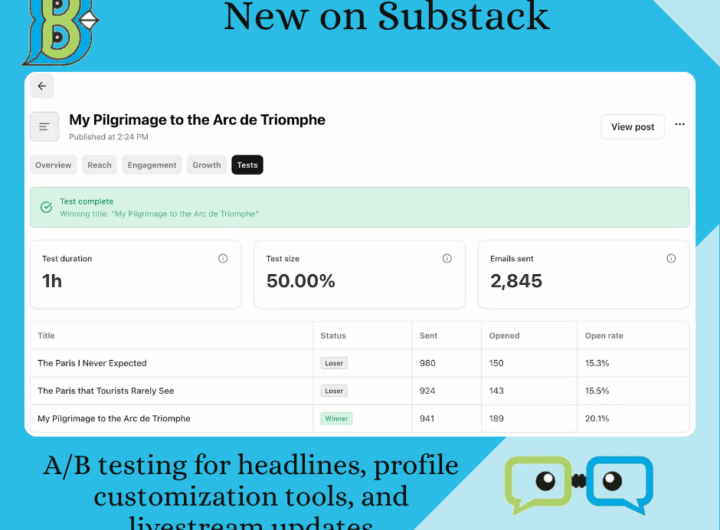

شرایط استفاده از سایت indeed.com  موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده

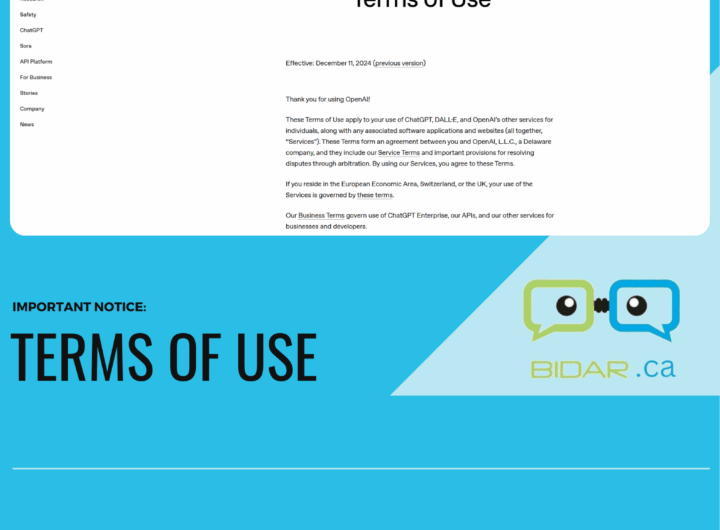

موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده  “شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)

“شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)  OPEN AI Terms in Farsi شرایط استفاده

OPEN AI Terms in Farsi شرایط استفاده  سرمایه داری داده و نژادپرستی الگوریتمی

سرمایه داری داده و نژادپرستی الگوریتمی  شفافیت در داده های ESG Data

شفافیت در داده های ESG Data