کشف تقلب،بهینهسازی تدارکات، نگارش هنر، انجام تحقیقات، ارائه ترجمه، همه این سیستمهای ماشینی هوشمند زندگی ما را برای بهتر شدن تغییر میدهند.

همانطور که این سیستم ها توانمندتر می شوند، دنیای ما هم کارآمدتر و در نتیجه غنی تر می شود.

غولهای فناوری مثل آلفابت، آمازون، فیسبوک، آیبیام و مایکروسافت – و همچنین افرادی مثل استیون هاوکینگ و ایلان ماسک – بر این باورند که اکنون زمان مناسبی برای صحبت در مورد چشمانداز تقریباً بیکران هوش مصنوعی است.

از بسیاری جهات، این به همان اندازه که برای فناوری نوظهور مرزی جدید است برای اخلاق و ارزیابی ریسک است.

پس کدام مسائل و صحبت ها کارشناسان هوش مصنوعی را بیخواب می کند؟

1. بیکاری.

بعد از بیکاری چه اتفاقی می افتد؟

سلسله مراتب کار در درجه اول به اتوماسیون مربوط می شود.

همانطور که راههایی برای خودکارسازی مشاغل ابداع کردهایم، میتوانیم فضایی را برای افراد ایجاد کنیم تا نقشهای پیچیدهتری را ایفا کنند، و از کار فیزیکی که بر جهان پیش از صنعتی شدن مسلط بود به کار مفهومی، که مشخصه کار استراتژیک و اداری در جامعه جهانیشده ما است، حرکت کنیم.

به حمل و نقل باری نگاه کنید: در حال حاضر میلیون ها نفر را در ایالات متحده مشغول کرده است.

اگر کامیون های خودران که وعده داده شده توسط ایلان ماسک تسلا در دهه آینده به طور گسترده در دسترس باشند، چه اتفاقی برای آنها خواهد افتاد؟

از سوی دیگر، اگر خطر کمتر تصادفات را در نظر بگیریم، کامیون های خودران یک انتخاب اخلاقی به نظر می رسند.

همین سناریو ممکن است برای کارکنان اداری و همچنین برای اکثریت نیروی کار در کشورهای توسعه یافته اتفاق بیفتد.

اینجاست که به این سوال می رسیم که چگونه وقت خود را بگذرانیم.

اکثر مردم هنوز به فروش وقت خود متکی هستند تا درآمد کافی برای تأمین زندگی خود و خانواده خود داشته باشند.

ما فقط میتوانیم امیدوار باشیم که این فرصت به مردم امکان میدهد تا در فعالیتهای غیر کارگری، مانند مراقبت از خانوادههای خود، تعامل با جوامع خود و یادگیری راههای جدید برای کمک به جامعه انسانی، معنا پیدا کنند.

اگر با این گذار موفق شویم، ممکن است روزی به گذشته نگاه کنیم و فکر کنیم که این وحشیانه بود که انسان ها مجبور بودند بیشتر زمان بیداری خود را بفروشند تا بتوانند فقط زندگی کنند.

2. نابرابری.

چگونه ثروت ایجاد شده توسط ماشین ها را توزیع کنیم؟

سیستم اقتصادی ما مبتنی بر جبران کمک به اقتصاد است که اغلب با استفاده از دستمزد ساعتی ارزیابی می شود. اکثر شرکت ها هنوز هم در مورد محصولات و خدمات به کار ساعتی وابسته هستند. اما با استفاده از هوش مصنوعی، یک شرکت می تواند اتکا به نیروی انسانی را به شدت کاهش دهد و این بدان معناست که درآمد به دست افراد کمتری می رسد. در نتیجه، افرادی که مالکیت شرکتهای مبتنی بر هوش مصنوعی را دارند، تمام پول را به دست خواهند آورد.

ما در حال حاضر شاهد افزایش شکاف ثروت هستیم، جایی که بنیانگذاران استارت آپ بخش بزرگی از مازاد اقتصادی را که ایجاد می کنند به خانه می برند. در سال 2014، سه شرکت بزرگ در دیترویت و سه شرکت بزرگ در دره سیلیکون تقریباً همان درآمد ایجاد کردند … فقط در سیلیکون ولی 10 برابر کمتر کارمندان وجود داشت.

اگر واقعاً یک جامعه پس از کار را تصور می کنیم، چگونه یک اقتصاد منصفانه پس از کار را ساختار می دهیم؟

3. انسانیت.

ماشینها چگونه بر رفتار و تعامل ما تأثیر میگذارند؟

رباتهای باهوش مصنوعی در مدلسازی مکالمات و روابط انسانی بهتر و بهتر میشوند. در سال 2015، رباتی به نام یوجین گوستمن برای اولین بار برنده چالش تورینگ شد.

در این چالش، ارزیابهای انسانی از ورودی متن برای چت کردن با یک موجود ناشناخته استفاده کردند، سپس حدس زدند که آیا با یک انسان یا یک ماشین چت میکردند.

یوجین گوستمن بیش از نیمی از ارزیابیکنندگان را فریب داد تا فکر کنند با یک انسان صحبت میکنند.

این نقطه عطف تنها آغاز عصری است که در آن ما به طور مکرر با ماشینها به گونهای تعامل خواهیم داشت که گویی انسان هستند.

چه در خدمات مشتری و چه در فروش.

در حالی که توجه و مهربانی انسان ها برای شخص دیگری محدود است، ربات های مصنوعی می توانند منابع تقریبا نامحدودی را برای ایجاد روابط هدایت کنند.

اگرچه بسیاری از ما از این موضوع آگاه نیستیم، اما در حال حاضر شاهد این هستیم که چگونه ماشینها میتوانند مراکز پاداش را در مغز انسان فعال کنند.

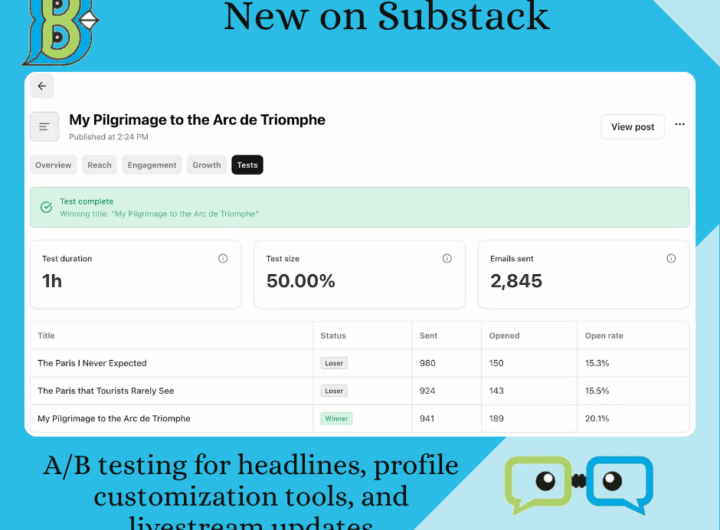

فقط به سرفصل های click-bait و بازی های ویدیویی نگاه کنید. این سرفصلها اغلب با تست A/B بهینه میشوند، شکلی ابتدایی از بهینهسازی الگوریتمی برای محتوا برای جلب توجه ما.

از این روش و روشهای دیگر برای معتاد کردن بازیهای ویدیویی و موبایلی متعدد استفاده میشود.

اعتیاد به فناوری، مرز جدید وابستگی انسان است.

از سوی دیگر، شاید بتوان به کاربرد متفاوتی از نرم افزار فکر کرد که قبلاً در جهت دهی توجه انسان و تحریک برخی اقدامات مؤثر بوده است.

در صورت استفاده صحیح، این می تواند به فرصتی برای سوق دادن جامعه به سمت رفتار سودمندتر تبدیل شود. با این حال، در دستانی اشتباه می تواند مضر باشد.

4. حماقت مصنوعی.

چگونه می توانیم از اشتباهات محافظت کنیم؟

هوش از یادگیری ناشی می شود، چه انسان باشید و چه ماشین.

سیستمها معمولاً یک مرحله آموزشی دارند که در آن «یاد میگیرند» الگوهای درست را شناسایی کرده و بر اساس ورودیهای آنها عمل کنند.

هنگامی که یک سیستم به طور کامل آموزش داده شد، سپس می تواند وارد مرحله آزمایشی شود، جایی که نمونه های بیشتری با آن برخورد می کنند و ما می بینیم که چگونه کار می کند.

بدیهی است که مرحله آموزش نمی تواند تمام نمونه های ممکنی را که یک سیستم ممکن است در دنیای واقعی با آنها سر و کار داشته باشد پوشش دهد.

این سیستم ها را می توان به گونه ای فریب داد که انسان ها چنین نمی کنند.

برای مثال، الگوهای نقطهای تصادفی میتوانند ماشین را به «دیدن» چیزهایی که آنجا نیستند سوق دهند.

اگر به هوش مصنوعی متکی باشیم تا ما را وارد دنیای جدیدی از کار، امنیت و کارایی کنیم، باید اطمینان حاصل کنیم که دستگاه مطابق برنامه ریزی شده عمل می کند و مردم نمی توانند بر آن غلبه کنند تا از آن برای اهداف خود استفاده کنند.

5. روبات های نژادپرست.

چگونه تعصب هوش مصنوعی را از بین ببریم؟

اگرچه هوش مصنوعی قادر به سرعت و ظرفیت پردازش بسیار فراتر از انسان است، اما همیشه نمی توان به منصفانه و بی طرف بودن آن اعتماد کرد.

گوگل و شرکت مادرش آلفابت یکی از پیشتازان در زمینه هوش مصنوعی هستند، همانطور که در سرویس عکس گوگل دیده می شود، جایی که هوش مصنوعی برای شناسایی افراد، اشیا و صحنه ها استفاده می شود.

اما ممکن است اشتباه پیش برود، مانند زمانی که دوربین حساسیت نژادی را از دست داده است، یا زمانی که نرم افزاری که برای پیش بینی مجرمان آینده استفاده می شود، سوگیری علیه سیاه پوستان نشان می دهد.

ما نباید فراموش کنیم که سیستمهای هوش مصنوعی توسط انسانهایی ساخته میشوند که میتوانند مغرضانه و قضاوتکننده باشند.

بار دیگر، اگر به درستی استفاده شود، یا توسط کسانی که برای پیشرفت اجتماعی تلاش می کنند، استفاده شود، هوش مصنوعی می تواند کاتالیزوری برای تغییرات مثبت باشد.

6. امنیت.

چگونه هوش مصنوعی را در برابر دشمنان ایمن نگه داریم؟

هرچه یک فناوری قدرتمندتر شود، می توان از آن به دلایل ناپسند و همچنین به نفع استفاده کرد.

این نه تنها در مورد رباتهایی که برای جایگزینی سربازان انسانی یا سلاحهای خودران تولید میشوند، بلکه در مورد سیستمهای هوش مصنوعی که در صورت استفاده بدخواهانه میتوانند باعث آسیب شوند صدق میکند.

از آنجایی که این دعواها فقط در میدان نبرد انجام نخواهند شد، امنیت سایبری اهمیت بیشتری پیدا خواهد کرد.

به هر حال، ما با سیستمی روبهرو هستیم که سریعتر و توانمندتر از ما به مراتب بزرگ تر است.

7. جن های شیطانی.

چگونه از پیامدهای ناخواسته محافظت کنیم؟

این فقط دشمنان نیستند که باید نگران آنها باشیم.

اگر هوش مصنوعی خود علیه ما باشد چه؟ این به معنای تبدیل “شیطان” به شیوه قدرت انسان، یا شیوه ای که فجایع هوش مصنوعی در فیلم های هالیوود به تصویر کشیده می شود، نیست.

در عوض، ما می توانیم یک سیستم هوش مصنوعی پیشرفته را به عنوان یک “جن در چراغ جادو” تصور کنیم که می تواند آرزوها را برآورده کند، اما با عواقب غیرقابل پیش بینی وحشتناکی.

در مورد یک ماشین، بعید است که سوء نیت در بازی وجود داشته باشد، فقط عدم درک زمینه کاملی که در آن آرزو انجام شده است.

یک سیستم هوش مصنوعی را تصور کنید که از آن خواسته می شود سرطان را در جهان ریشه کن کند.

پس از محاسبات زیاد، فرمولی را بیرون میدهد که در واقع با کشتن همه افراد روی این سیاره، سرطان را به پایان میرساند.

کامپیوتر می توانست به هدف خود یعنی «نه سرطان دیگر» بسیار کارآمد دست یابد، اما نه آنطور که انسان ها در نظر داشتند.

8. تکینگی. (Singularity)

چگونه کنترل یک سیستم هوشمند پیچیده را حفظ کنیم؟

دلیل اینکه انسان در بالای زنجیره غذایی قرار دارد، دندان های تیز یا ماهیچه های قوی نیست.

تسلط انسان تقریباً به طور کامل ناشی از نبوغ و هوش ماست.

ما میتوانیم از حیوانات بزرگتر، سریعتر و قویتر استفاده کنیم، زیرا میتوانیم ابزارهایی برای کنترل آنها ایجاد کنیم و از آنها استفاده کنیم: هم ابزارهای فیزیکی مانند قفس و سلاحها و هم ابزارهای شناختی مانند آموزش و آمادهسازی.

این یک سوال جدی در مورد هوش مصنوعی ایجاد می کند: آیا روزی همان مزیت را نسبت به ما خواهد داشت؟

ما نمی توانیم فقط به “کشیدن دوشاخه” تکیه کنیم، زیرا یک ماشین به اندازه کافی پیشرفته ممکن است این حرکت را پیش بینی کند و از خود دفاع کند.

این همان چیزی است که برخی آن را «تکینگی» مینامند: زمانی که انسانها دیگر باهوشترین موجودات روی زمین نیستند.

9. حقوق ربات ها.

چگونه رفتار انسانی با هوش مصنوعی را تعریف کنیم؟

در حالی که دانشمندان علوم اعصاب هنوز روی کشف اسرار تجربه آگاهانه کار می کنند، ما بیشتر در مورد مکانیسم های اساسی پاداش و بیزاری می دانیم.

ما این مکانیسم ها را حتی با حیوانات ساده به اشتراک می گذاریم. به نوعی، ما در حال ساختن مکانیسمهای مشابهی برای پاداش و بیزاری در سیستمهای هوش مصنوعی هستیم.

به عنوان مثال، یادگیری تقویتی مشابه آموزش سگ است: بهبود عملکرد با یک پاداش مجازی تقویت می شود.

در حال حاضر، این سیستم ها نسبتاً سطحی هستند، اما پیچیده تر و شبیه به زندگی می شوند.

آیا میتوانیم سیستمی را زمانی که عملکردهای پاداش آن ورودی منفی به آن میدهند، در حال رنج بودن بدانیم؟

علاوه بر این، به اصطلاح الگوریتمهای ژنتیک با ایجاد نمونههای بسیاری از یک سیستم به طور همزمان کار میکنند، که تنها موفقترین آنها «بقا» میکنند و برای تشکیل نسل بعدی نمونهها ترکیب میشوند.

این در طول نسلهای زیادی اتفاق میافتد و راهی برای بهبود یک سیستم است. نمونه های ناموفق حذف می شوند. در چه مرحله ای می توانیم الگوریتم های ژنتیک را نوعی قتل عام در نظر بگیریم؟

وقتی ماشینها را بهعنوان موجوداتی در نظر بگیریم که میتوانند درک کنند، احساس کنند و عمل کنند، جهش بزرگی نیست که در مورد وضعیت قانونی آنها هم فکر کنیم.

آیا باید با آنها مانند حیواناتی با هوش مشابه رفتار کرد؟ آیا ما رنج ماشین های “احساس” را در نظر خواهیم گرفت؟

برخی از سؤالات اخلاقی در مورد کاهش رنج و برخی در مورد خطر پیامدهای منفی هستند.

در حالی که ما این خطرات را در نظر می گیریم، باید در نظر داشته باشیم که در کل، این پیشرفت تکنولوژیکی به معنای زندگی بهتر برای همه است.

هوش مصنوعی پتانسیل وسیعی دارد و اجرای مسئولانه آن به عهده ماست.

منبع:

https://www.weforum.org/agenda/2016/10/top-10-ethical-issues-in-artificial-intelligence/

شرایط استفاده از سایت indeed.com

شرایط استفاده از سایت indeed.com  موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده

موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده  “شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)

“شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)  OPEN AI Terms in Farsi شرایط استفاده

OPEN AI Terms in Farsi شرایط استفاده  سرمایه داری داده و نژادپرستی الگوریتمی

سرمایه داری داده و نژادپرستی الگوریتمی  شفافیت در داده های ESG Data

شفافیت در داده های ESG Data