ai-harmful-bios

امروزه، فناوریهای هوش مصنوعی و یادگیری ماشینی بر برخی از تصمیمهای ما تأثیر میگذارند و حتی برخی از آنها را میگیرند، که از آنها نشان میدهد که به چه کسی آزادی مشروط داده میشود. در حالی که این موارد کاربرد پیچیدهای هستند، اما نشاندهنده اوج انقلاب آینده هستند، با نوآوریهای علم داده که نوید تغییر نحوه تشخیص بیماری، مبارزه با تغییرات آبوهوایی و حل سایر چالشهای اجتماعی را میدهد. با این حال، از آنجایی که برنامههای کاربردی در حوزههای حساسی مانند امور مالی و مراقبتهای بهداشتی مستقر میشوند، کارشناسان و طرفداران هشدار در مورد ظرفیت سیستمهای هوش مصنوعی برای تصمیمگیری بیطرفانه یا بهطور سیستماتیک برای گروههای خاصی از مردم ناعادلانه هستند. هوش مصنوعی مغرضانه بدون توجه میتواند تعصبات مضر انسانی را تداوم بخشد و حتی آن را تقویت کند.

سازمانها احتمالاً مدلهای AI/ML را برای تقویت عمدی نابرابریها طراحی نمیکنند. با این حال، سوگیری همچنان به اشکال مختلف در الگوریتمها نفوذ میکند، حتی زمانی که متغیرهای حساسی مانند جنسیت، قومیت یا هویت جنسی را حذف میکند. مشکل اغلب در داده های مورد استفاده برای آموزش مدل ها نهفته است که منعکس کننده نابرابری های منبع آن است: دنیای اطراف ما. ما قبلاً اثرات الگوریتمهای استخدامی را میبینیم که به نفع مردان است و مدلهای کد مولد که کلیشهها را منتشر میکنند. خوشبختانه، مدیران میدانند که باید اقدام کنند، با نظرسنجی اخیر که نشان میدهد بیش از ۵۰ درصد از مدیران نگرانیهای «عمده» یا «افراطی» در مورد خطرات اخلاقی و اعتباری ناشی از استفاده سازمانشان از هوش مصنوعی را گزارش میدهند.

اینکه چگونه سازمان ها باید برای حذف سوگیری های غیرعمدی اقدام کنند، چندان روشن نیست. در حالی که بحث در مورد سیستمهای هوش مصنوعی اخلاقی اکنون سرفصلها و بررسیهای نظارتی را به خود اختصاص داده است، بحث کمی در مورد اینکه چگونه میتوانیم پزشکان را برای مقابله با مسائل ناعادلانه آماده کنیم وجود دارد. در زمینهای که تا همین اواخر، تمرکز بر روی افزایش محدودیتهای ممکن بود، تعصب در مدلها تنها تقصیر توسعهدهندگان نیست. حتی دانشمندان داده با بهترین نیت اگر ابزار، پشتیبانی و منابع مورد نیاز برای کاهش آسیب را نداشته باشند، با مشکل مواجه خواهند شد.

در حالی که منابع بیشتری در مورد هوش مصنوعی مسئول و منصفانه در سال های اخیر در دسترس قرار گرفته است، پیمایش در این پویایی ها بیش از بحث های میزگرد و دوره های یکباره نیاز دارد. ما به یک رویکرد کل نگر برای آموزش در مورد سوگیری در هوش مصنوعی نیاز داریم، رویکردی که همه از دانشآموزان گرفته تا رهبری اجرایی سازمانهای پیشرو را درگیر کند.

کمتر از یک چهارم مربیان گزارش می دهند که در کلاس های خود آموزش های اخلاقی هوش مصنوعی ارائه می دهند (اولیویه لو موآل / شاتر استوک)

در اینجا یک آموزش عمدی، مستمر و حرفه ای در مورد هوش مصنوعی اخلاقی می تواند به نظر برسد:

در مدرسه: آموزش رهبران فردا، امروز

بهترین راه برای آمادهسازی رهبران آینده برای پرداختن به پیامدهای اجتماعی و اخلاقی محصولاتشان، گنجاندن دستورالعملهایی درباره سوگیری و برابری در آموزش رسمیشان است. در حالی که این امر کلیدی است، هنوز در اکثر برنامه ها نادر است. در نظرسنجی Anaconda’s State of Data Science در سال 2021، هنگامی که در مورد موضوعاتی که به دانشآموزان علوم داده/ML آموزش داده میشود، تنها 17% و 22% از مربیان پاسخ دادند که به ترتیب در مورد اخلاق یا سوگیری تدریس میکنند.

دانشگاه ها باید به دنبال زمینه های حرفه ای تثبیت شده برای راهنمایی باشند. اخلاق پزشکی را در نظر بگیرید که موضوعات مشابه را در تقاطع نوآوری و اخلاق بررسی می کند. به دنبال آئین نامه اخلاق پزشکی که توسط انجمن پزشکی آمریکا در سال 1847 به تصویب رسید، این مطالعه به یک حوزه فرعی مجزا تبدیل شد و اصول راهنمای آن اکنون برای کسانی که به دنبال اعتبار حرفه ای به عنوان پزشک و پرستار هستند، نیاز به یادگیری دارد. مؤسسات آموزشی بیشتری باید از دانشگاه آکسفورد در ایجاد مراکز اختصاصی که در زمینههای متعدد، مانند فلسفه، برای هدایت آموزش در مورد انصاف و بیطرفی در هوش مصنوعی استفاده میکنند، پیروی کنند.

همه موافق نیستند که کلاسهای مستقل اخلاق هوش مصنوعی، که اغلب به وضعیت انتخابی تنزل داده میشوند، مؤثر خواهند بود. رویکرد جایگزینی که توسط دانشگاهیان پیشنهاد شده و اخیراً توسط هاروارد پذیرفته شده است، «قرار دادن» اخلاق در آموزش فنی با ایجاد لحظات معمول برای ایجاد مهارتهای اخلاقی و تفکر در طول فعالیتهای عادی است. و سپس بسیاری از دانشمندان مشتاق داده وجود دارند که مسیر سنتی دانشگاه را دنبال نمی کنند. حداقل برنامههای کوتاه حرفهای باید از دورههای آنلاین رایگان موجود در دانشگاه میشیگان و سایرین استفاده کنند. همانطور که آزمایشگاه رسانه MIT با پروژه برنامه درسی AI + Ethics برای مدرسه راهنمایی توصیه می کند، حتی موردی برای معرفی موضوع حتی زودتر وجود دارد.

در محل کار: ارتقاء مهارت در اخلاق

آموزش رسمی در مورد سوگیری در AI/ML تنها اولین گام به سوی توسعه حرفه ای واقعی در زمینه پویایی مانند علم داده است. با این حال، نظرسنجی Anaconda’s State of Data Science در سال 2021 نشان داد که 60 درصد از سازمانهای علم داده یا هنوز هیچ برنامهای برای اطمینان از انصاف و کاهش تعصب در مجموعهها و مدلهای داده اجرا نکردهاند، یا نتوانستهاند این برنامهها را به کارکنان ابلاغ کنند. به طور مشابه، یک نظرسنجی اخیر از مدیران IT توسط ZDNet نشان داد که 58٪ از سازمان ها هیچ آموزش اخلاقی به کارکنان خود ارائه نمی دهند.

مدیران اجرایی نگران تاثیر هوش مصنوعی بر شهرت شرکت هایشان (FGC/Shutterstock)

پاسخ فقط این نیست که تیمهای هوش مصنوعی را مجبور به آموزش اصول اخلاقی بشمارند. یک برنامه آموزشی باید جزئی از تلاش های کل سازمان برای افزایش آگاهی و اقدام در جهت کاهش سوگیری مضر باشد. پیشرفته ترین شرکت ها اخلاق هوش مصنوعی و مسئولیت پذیری را اولویت های اتاق هیئت مدیره قرار می دهند، اما اولین قدم خوب، تنظیم استانداردهای اخلاق داخلی و اجرای ارزیابی های دوره ای برای اطمینان از برقراری آخرین شیوه ها است. به عنوان مثال، تیم ها باید گرد هم آیند تا تعریف کنند که اصطلاحاتی مانند سوگیری و توضیح پذیری در زمینه عملیات خود به چه معناست. برای برخی از پزشکان، سوگیری میتواند به الگوها و روابطی اشاره داشته باشد که سیستمهای ML به دنبال شناسایی آن هستند، در حالی که برای برخی دیگر، این اصطلاح یک بار معنایی منفی دارد.

با وجود استانداردها، آموزش می تواند دستورالعمل ها را عملیاتی کند. هاروارد بیزینس ریویو توصیه می کند که فراتر از افزایش آگاهی ساده رفته و به جای آن به کارکنان در سراسر سازمان قدرت دهید تا سؤالات خود را بپرسند و نگرانی ها را به طور مناسب افزایش دهند. برای تیم های فنی و مهندسی، شرکت ها باید آماده سرمایه گذاری در ابزارهای تجاری جدید یا پوشش هزینه های آموزش تخصصی شخص ثالث باشند. با توجه به اینکه دو سوم شرکتهایی که در مطالعه اخیر FICO شرکت کردند، نمیتوانند توضیح دهند که چگونه راهحلهای هوش مصنوعی پیشبینیهای خود را انجام میدهند، توسعهدهندگان و مهندسان به چیزی بیش از کارگاههای ساده یا دورههای گواهی نیاز خواهند داشت.

آموزش اخلاق هوش مصنوعی نیز باید سنگ بنای استراتژی استخدام بلندمدت شما باشد. اول، ارائه آموزش های اخلاقی، استعدادهای جوان و ارزش محور را جذب می کند. اما ابتکارات رسمی برای پرورش این مهارتها، یک حلقه بازخورد مثبت نیز ایجاد میکند، که در آن شرکتها از برنامههای آموزشی خود برای نشان دادن مهارتهایی که کارفرمایان به دنبال آن هستند به دانشگاهها استفاده میکنند و این مؤسسات را به گسترش پیشنهادات خود سوق میدهند. با ارائه آموزش در مورد این موضوعات امروز، رهبران می توانند به ایجاد نیروی کاری آماده و قادر به رویارویی با مسائلی که فقط پیچیده تر می شوند کمک کنند.

گفتگوها در مورد اخلاق هوش مصنوعی در چند سال گذشته محل بحث ثابتی بوده است و اگرچه ممکن است نادیده گرفتن این مکالمات آسان باشد، بسیار مهم است که اجازه ندهیم اخلاق هوش مصنوعی تبدیل به یک کلمه کلیدی دیگر شود. با قوانین به روز شده اتحادیه اروپا و مقررات عمومی حفاظت از داده ها (GDPR)، مکالمات و مقررات در مورد استفاده از هوش مصنوعی اینجا باقی می مانند. در حالی که کاهش سوگیری مضر یک فرآیند تکراری خواهد بود، متخصصان و سازمانها باید در ارزیابی مدلهای خود و پیوستن به مکالمات پیرامون اخلاق هوش مصنوعی هوشیار باشند.

درباره نویسنده: کوین گلداسمیت به عنوان مدیر ارشد فناوری Anaconda، Inc.، ارائهدهنده محبوبترین پلتفرم علم داده در جهان با بیش از 25 میلیون کاربر، خدمت میکند. در نقش خود، او بیش از 29 سال تجربه در توسعه نرم افزار و مدیریت مهندسی را برای تیم به ارمغان می آورد، جایی که او بر نوآوری برای پیشنهادات منبع باز و تجاری فعلی Anaconda نظارت می کند. گلداسمیت همچنین برای ایجاد راه حل های جدید برای گردهم آوردن متخصصان علم داده با مبتکران، فروشندگان و رهبران فکری در صنعت کار می کند.

قبل از پیوستن به آناکوندا، او به عنوان CTO شرکت مدیریت هویت مبتنی بر هوش مصنوعی Onfido خدمت می کرد. نقش های دیگر شامل CTO در Avvo، معاون مهندسی، مصرف کننده در Spotify و نه سال در Adobe Systems به عنوان مدیر مهندسی بوده است. او همچنین نقش مهندسی نرم افزار در مایکروسافت و IBM را بر عهده داشته است.

منبع:

Fighting Harmful Bias in AI/ML with a Lifelong Approach to Ethics Training

شرایط استفاده از سایت indeed.com

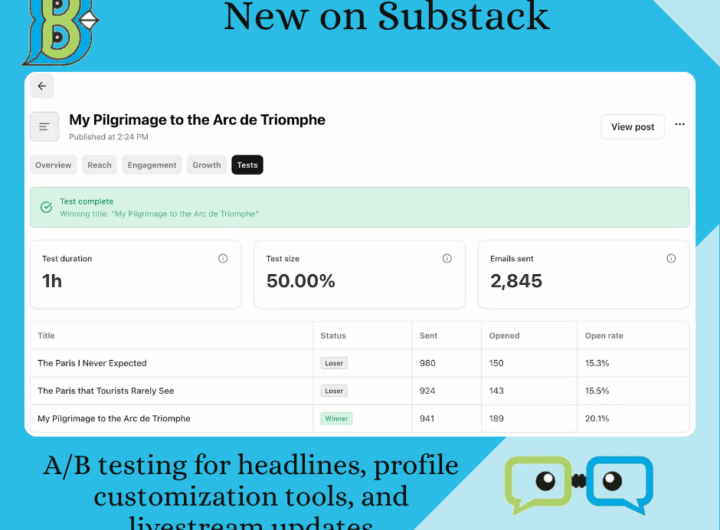

شرایط استفاده از سایت indeed.com  موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده

موارد جدید در Substack: تست A/B برای تیترها، ابزارهای سفارشیسازی پروفایل و بهروزرسانیهای پخش زنده  “شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)

“شرایط استفاده” OpenAI (منتشرشده در ۱۱ دسامبر ۲۰۲۴)  OPEN AI Terms in Farsi شرایط استفاده

OPEN AI Terms in Farsi شرایط استفاده  سرمایه داری داده و نژادپرستی الگوریتمی

سرمایه داری داده و نژادپرستی الگوریتمی  شفافیت در داده های ESG Data

شفافیت در داده های ESG Data